Categoria: Formazione e lavoro

Guida alla PlayList "Progettazione e sviluppo database con MySQL"

![]() Gino Visciano |

Gino Visciano |

Skill Factory - 08/11/2021 17:35:03 | in Formazione e lavoro

Skill Factory - 08/11/2021 17:35:03 | in Formazione e lavoro

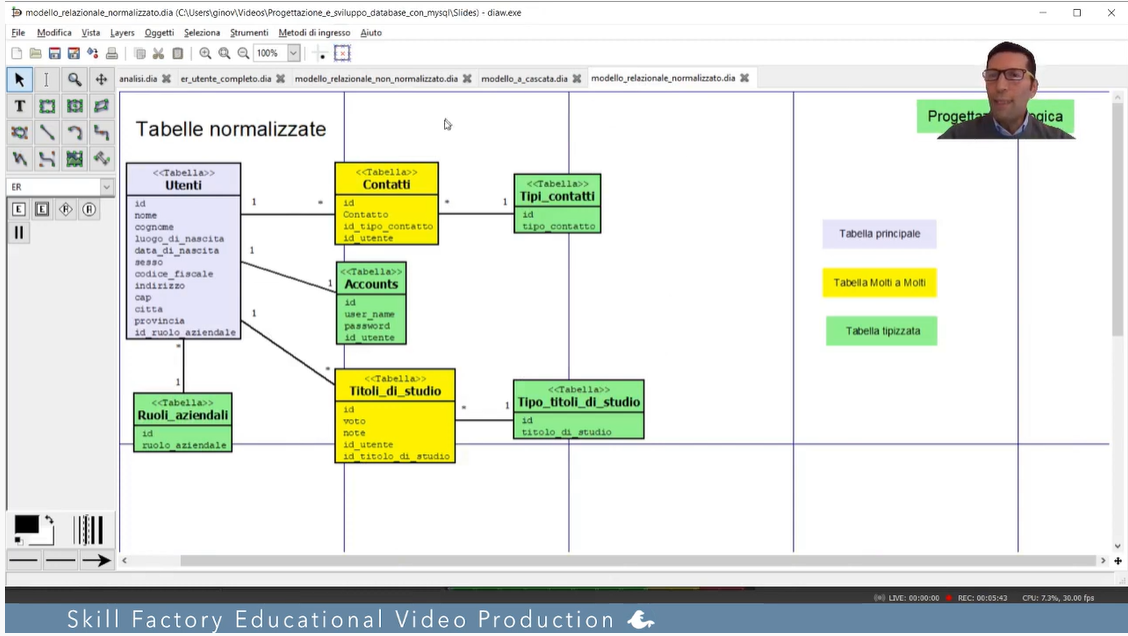

La PlayList "Progettazione e sviluppo database con MySQL", pubblicata su Skill Factory Channel, contiene le lezioni per imparare a progettare e sviluppare un database con il linguaggio SQL.

La PlayList "Progettazione e sviluppo database con MySQL", pubblicata su Skill Factory Channel, contiene le lezioni per imparare a progettare e sviluppare un database con il linguaggio SQL.

Come DBMS (Database Management System) abbiamo scelto MySQL, sia per la semplicità d'installazione e configurazione, sià per le caratteristiche che lo rendono molto simile a DBMS più professionali.

Gli obiettivi delle lezioni sono quelli di apprendere le competenze sia teoriche, sia pratiche per:

1 - progettare un database relazionale;

2 - disegnare i seguenti diagrammi: Entità Relazione, Modello Relazionale, Schema Fisico;

3 - applicare i comandi SQL: Data Definition Language, per creare e gestire la struttura di un database;

4 - applicare i comandi SQL: Data Manipulation Language, per gestire il contenuto delle tabelle;

5 - applicare i comandi SQL: Data Query Language, per interrogare le tabelle )(query) o creare report professionali (view);

6 - applicare i comandi SQL:Data Control Language, per gestire le autorizzazioni ed i permessi degli utenti.

Destinatari:

Studenti;

Giovani che vogliono lavorare in un'azienda IT;

Insegnanti d'istituti superiori ad indirizzo informatico;

Dipendenti di aziende IT che vogliono riqualificarsi.

Per accedere alla PlayList per seguire le lezioni clicca qui.

RISORSE

- -- ARTEFATTI- --

Modello Relazionale normalizzato (Utenti)

Schema Fisico (Utenti)

Creazione Database (Utenti)

Creazione indici (Utenti)

Creazione vincoli d'integrità referenziale

- -- SCRIPT- --

Per svolgere i laboratori proposti dal docente Gino Visciano, clicca qui per scaricare lo script da eseguire per creare il database db_rubrica.

Se hai completato gli studi, sei inoccupato e vuoi lavorare in un'azienda IT, per partecipare ad un percorso di accompagnamento al lavoro con la Skill Factory, invia il tuo curriculum a recruiting@skillfactory.it, verrai contattato da un nostro recruiter che risponderà alle tue domande e valutarà l'idoneità di partecipazione.

Se hai completato gli studi, sei inoccupato e vuoi lavorare in un'azienda IT, per partecipare ad un percorso di accompagnamento al lavoro con la Skill Factory, invia il tuo curriculum a recruiting@skillfactory.it, verrai contattato da un nostro recruiter che risponderà alle tue domande e valutarà l'idoneità di partecipazione.

Per i giovani in cerca di lavoro crescono le opportunità d'impiego nel settore del Software Testing

![]() Gino Visciano |

Gino Visciano |

Skill Factory - 16/06/2021 09:55:04 | in Formazione e lavoro

Skill Factory - 16/06/2021 09:55:04 | in Formazione e lavoro

L'evoluzione digitale inevitabilmente sta favorendo il settore dello sviluppo software, questo oltre ad aumentare la domanda di programmatori, sta facendo crescere anche la richiesta di Software Tester.

L'evoluzione digitale inevitabilmente sta favorendo il settore dello sviluppo software, questo oltre ad aumentare la domanda di programmatori, sta facendo crescere anche la richiesta di Software Tester.

Il software, prima di essere immesso sul mercato, deve essere collaudato e testato, questa fase viene definita Software Testing ed è fondamentale per garantire la qualità del prodotto, la sua completezza ed affidabilità.

Il ruolo del Software Tester per un'azienda IT è molto importante, il team di testing è complementare al team dei programmatori e deve garntire che vengano rispettate le specifiche funzionali e non funzionali dei prodotti sviluppati.

Il Software Tester riveste un ruolo importante nel ciclo di vita di un software ed è fondamentale per l’immagine dell’azienda, perché il suo lavoro evita le cattive prestazioni del prodotto software e di conseguenza scongiura ricadute negative sul mercato, favorendo il business aziendale.

I compiti che un Software Tester svolge, sono principalemente questi:

- Pianifica e implementa strategie di testing;

- Disegna casi di test;

- Individua i malfunzionamenti del prodotto e le relative cause attraverso attività di debugging ed error fixing;

- Collabora con il team di sviluppo per correggere o migliorare il software;

- Scrive programmi di test per verificare la presenza di anomalie nel software;

- Utilizza strumenti software per automatizzare le procedure di testing.

Per svolgere il proprio lavoro il Software Tester deve avere le seguenti competenze tecniche:

- Conoscenza fondamentali dei linguaggi di programmazione utilizzati lato front-end e back-end, come ad esempio: C++, C#, Java, Python, PHP, Javascript, HTML/CSS;

- Conoscenza delle principali metodologie e paradigmi di sviluppo software;

- Esperienza con Linux e Windows, nonché con i principali strumenti di scripting;

- Conoscenza dei principali prodotti di Office Automation con la capacità di creare documentazione, report e collaborare in rete;

- Esperienza nell'analisi dei dati;

- Conoscenza del linguggio SQL e del funzionamento dei più importanti DBMS;

- Conoscenza del linguaggio UML;

- Conoscenza ed esperienza pratica con uno o più strumenti di gestione dei test (per esempio JIRA);

- Esperienza di test automation con JUnit e/o NUnit, Jenkins, Jmeter, SoapUI e/o Postman;

- Esperianza Selenium WebDriver & Cucumber.

COME DIVENTARE SOFTWARE TESTER

Se sei un giovane in cerca di lavoro, con conoscenze di base d'informatica, per diventare Software Tester è sufficiente partecipare alla prossima Skill Factory in modalità FAD, in partenza a luglio.

L'obiettivo di questa Skill Factory è quello di formare gratuitamente Software Tester durante il mese di luglio ed inserirli presso un nostro partener IT di Napoli a settembre.

L'obiettivo di questa Skill Factory è quello di formare gratuitamente Software Tester durante il mese di luglio ed inserirli presso un nostro partener IT di Napoli a settembre.

Dopo aver frequentato la Skill Factory per Software Tester, potrai sostenere l'esame per acquisire la certificazione ISTQB, che certifica che hai le competenze per lavorare nell’ambito del Software Testing.

Per maggiori informazioni sulla certificazione ISTQB clicca qui.

Per partecipare gratuitamente alla Skill Fcatory di luglio, per Software Tester e lavorare presso un nostro partner IT di Napoli, invia il tuo curriculum all'indirizzo mail: recruiting@skillfactory.it

Buon primo maggio, con l'obiettivo d'impegnarci sempre di più per favorire l'inserimento dei giovani nel mondo del lavoro...

![]() Gino Visciano |

Gino Visciano |

Skill Factory - 01/05/2021 15:13:29 | in Formazione e lavoro

Skill Factory - 01/05/2021 15:13:29 | in Formazione e lavoro

![]() Per chi come noi è impegnato quotidianamente a trasmettere competenze per creare posti di lavoro, la festa del primo maggio assume un'importanza particolare, perché sappiamo che il lavoro non si crea semplicemente con gli annunci e le buone intenzioni, ma per creare lavoro serve l'impegno e la sinergia di tutti gli attori che operano nel settore dell'istruzione, della formazione e delle politiche attive del lavoro.

Per chi come noi è impegnato quotidianamente a trasmettere competenze per creare posti di lavoro, la festa del primo maggio assume un'importanza particolare, perché sappiamo che il lavoro non si crea semplicemente con gli annunci e le buone intenzioni, ma per creare lavoro serve l'impegno e la sinergia di tutti gli attori che operano nel settore dell'istruzione, della formazione e delle politiche attive del lavoro.

Qualunque profilo professionale non nasce per caso, ma è il risultato di un percorso di crescita e sacrificio, che inizia con la scuola superiore e potrebbe anche non finire mai, perché come accade per tutte le cose, il cambiamento ci impone di acquisire continuamente nuove competenze per rimanere aggiornati ed essere al passo coi tempi.

Quando nel 2011 ho fondato la Skill Factory, avevo già un'esperienza di 25 anni nel settore della formazione IT, lavoravo come formatore per l'Olivetti, l'Elea, l'IBM, la Microsoft, la Sun Microsystem e la Oracle.

Ho deciso di abbandonare la mia attività professionale, per dedicarmi alla Skill Factory, perché ho capito che la formazione, se finalizzata all'inserimento dei giovani nel mondo del lavoro, è più gratificante.

Grazie alla scelta di fare formazione solo se finalizzata alla creazione di posti di lavoro, oggi tantissmi giovani possono acquisire gratuitamente le competenze che servono per entrare nel mondo del lavoro ed iniziare la loro carriera professionale presso uno dei nostri partner IT.

Chiudo questo articolo con un suggerimento per chi può assumere decisioni nell'ambito delle politiche attive del lavoro...

Il tirocinio extracurriculare è lo strumento più utilizzato dalle aziende per offrire ai giovani diplomati o laureati l'opportunità di apprendere direttamente in azienda le competenze pratiche necessarie per svolgere il proprio ruolo professionale e non solo! Naturalmente esiste una regolamentazione che definisce i limiti del numero di tirocinanti per azienda.

Almeno per questo periodo di difficoltà, eliminate il limite del numero dei tirocinanti che un'azienda può prendere in stage, offrendo una premialità alle aziende che trasformano i contratti di tirocinio in contratti di apprendistato e delle penalizzazioni a quelle che non lo fanno.

Buon primo maggio a tutti!!!

Formiamo e assumiamo programmatori APEX in ambito Salesforce, partecipa anche tu alla Skill Factory "Apex Developer"

![]() Gino Visciano |

Gino Visciano |

Skill Factory - 27/10/2020 00:04:04 | in Formazione e lavoro

Skill Factory - 27/10/2020 00:04:04 | in Formazione e lavoro

CHE COS'E' SALESFORCE

Salesforce è nato nel 1999 a San Francisco, è un CRM basato sul Cloud. CRM è l'acronimo di "Customer Relationship Management" (Gestione delle relazioni con i clienti), permette di gestire le informazioni più importanti sui clienti e migliorare l'efficienza delle vendite.

Salesforce è nato nel 1999 a San Francisco, è un CRM basato sul Cloud. CRM è l'acronimo di "Customer Relationship Management" (Gestione delle relazioni con i clienti), permette di gestire le informazioni più importanti sui clienti e migliorare l'efficienza delle vendite.

Con un'unica piattaforma è possibile vendere, fornire assistenza, fare marketing, collaborare, analizzare il comportamento dei clienti e molto altro ancora.

Le principali funzionalità offerte da Salesforce sono:

- Gestione contatti dei clienti;

- Report e dashboard per una panoramica aziendale in tempo reale;

- Gestione trattative;

- Gestione dei lead (potenziali clienti);

- Integrazione con le principali applicazioni email;

- Gestione dei partner;

- Condivisione di file;

- Offrire dati analitici più approfonditi;

- Identificare modelli di comportamento e tendenze su cui agire;

- Analizzare le interazioni dei clienti con canali, messaggi e contenuti.

CHE COS'E' IL CLOUD COMPUTING

I servizi di questa potente piattaforma sono disponibili attraverso Internet, in cloud, quindi chiunque può dimensionare il CRM alle proprie esigenze aziendali, perché sono disponibili diverse soluzioni per piccole, medie e grandi aziende.

I servizi di questa potente piattaforma sono disponibili attraverso Internet, in cloud, quindi chiunque può dimensionare il CRM alle proprie esigenze aziendali, perché sono disponibili diverse soluzioni per piccole, medie e grandi aziende.

Il cloud computing permette di distribuire servizi di calcolo, come server, risorse di archiviazione, database, rete, software, analisi e intelligence, attraverso Internet, offrendo la possibilità di pagare solo per i servizi cloud usati, permettendoti di risparmiare sui costi operativi. L'infrastruttura cloud è scalabile e in modo più efficiente permette di dimensionare le risorse in base all'evoluzione delle esigenze aziendali.

CHE COS'E' APEX

Apex è Il linguaggio di programmazione usato per personalizzare Salesforce, è un linguaggio fortemente tipizzato ed orientato agli oggetti, che consente di eseguire istruzioni di controllo del flusso e delle transazioni su un server con piattaforma Lightning in combinazione con le chiamate all'API Lightning Platform. Mediante una sintassi dall'aspetto simile a Java e dal funzionamento simile alle procedure memorizzate in un database, Apex consente agli sviluppatori di aggiungere una logica applicativa alla maggior parte degli eventi di sistema, compresi i clic sui pulsanti, gli aggiornamenti dei record correlati e le pagine Visualforce.

Apex Code può essere avviato da richieste di servizi Web e da trigger per gli oggetti.

COME PARTECIPARE ALLA SKILL FACTORY "APEX DEVELOPER"

Per partecipare alla Skill Factory "Apex Developer", dovete aver completato gli studi (diploma o laurea), essere disoccupati, avere un'età compresa tra i 19 e 28 anni se diplomati, fino a 32 anni solo se laureati in discipline tecniche o scientifiche oppure se già programmi in Java e vuoi migliorare la tua posizione di lavoro.

Se completi con successo questa Skill Factory, è richiesta la disponibilità immediata a lavorare presso uno dei nostri partners IT di Napoli con le seguenti modalità di collaborazione:

Tirocinio e successivamente Apprendistato oppure contratto a tempo indeterminato se non è applicabile l'apprendistato.

Per partecipare ai test di selezione invia il tuo curriculum all'indirizzo mail: recruitng@skillfactory.it, entro l' 11 novembre 2020.

Sei già connesso a www.skillbook.it, clicca qui per inviare il tuo cv elettronico.

MODALITA' DIDATICHE DELLA SKILL FACTORY "APEX DEVELOPER"

La Skill Factory "Apex Developer" è gratuita ed ha una durata di 240 ore, dal 16 novembre 2020 all' 8 gennaio 2021.

Le attività didattiche verranno svolte in modalità FAD attraverso le piattaforme www.skillbook.it e Microsoft Teams.

Contenuti

Progettazione e sviluppo Database con SQL

Fondamenti di logica di programmazione con JAVA

Java Object Oriented

Panoramica su Salesforce

Apex

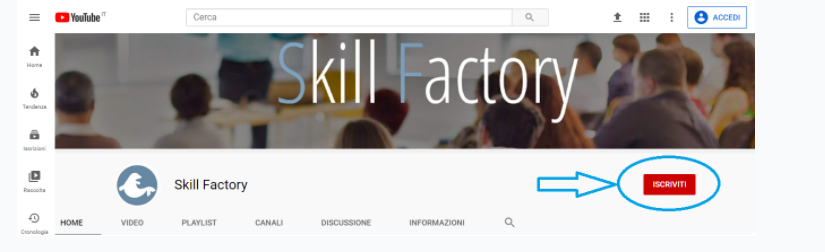

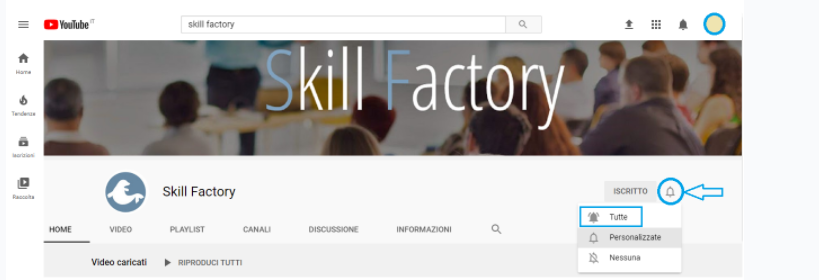

ISCRIVITI AL NOSTRO CANALE YOUTUBE

Per apprendente velocemente le competenze che ti servono per partecipare alla Skill Factory "Apex Developer", segui i corsi pubblicati sul nostro canale YouTube "Skill Factory channel".

Per iscriverti al canale devi essere in possesso di un account Google, se non hai ancora un account clicca qui.

Se sei già in possesso di un account Google, prosegui nel modo seguente:

1) Collegati al tuo account Gmail

2) Vai sul sito ufficiale di YouTube

3) Cliccare su Accedi

4) Inserisci user e password del tuo account Google

5) Clicca sul pulsante seguente:

6) Per iscriverti clicca sul pulsante indicato

7) Non dimenticare di attivare le notifiche

Buona formazione!

Ad ottobre, in partnership con KEYTECH, parte la Skill Factory SAP Essential, in modalità Smart Learning. L'attività di formazione è fondamentale per chi vuole lavorare in una media o grande azienda.

![]() Gino Visciano |

Gino Visciano |

Skill Factory - 05/10/2020 23:06:01 | in Formazione e lavoro

Skill Factory - 05/10/2020 23:06:01 | in Formazione e lavoro

CHE COS'E' SAP

SAP è il più noto ERP, diffusissimo tra le medie e grandi aziende. Se hai studiato economia e gestione aziendale, la conoscenza di un Enterprise Resource Planning come SAP è un prerequisito importante per poter lavorare in un'azienda che gestisce processi di business come le vendite, gli acquisti, la gestione del magazzino, la finanza, la contabilità, ecc.

SAP è il più noto ERP, diffusissimo tra le medie e grandi aziende. Se hai studiato economia e gestione aziendale, la conoscenza di un Enterprise Resource Planning come SAP è un prerequisito importante per poter lavorare in un'azienda che gestisce processi di business come le vendite, gli acquisti, la gestione del magazzino, la finanza, la contabilità, ecc.

SAP offre opportunità di lavoro anche ai laureati con qualunque tipo di specializzazione informatica, perché possono imparare a programmare con ABAP il linguaggio di programmazione che permette di personalizzare i sistemi SAP oppure possono imparare ad usare SAP Fiori la suite di web app rivolta a tutte quelle aziende che manifestano l’esigenza di un monitoraggio e una gestione completa anche da remoto, attraverso l'uso di Smartphone e Tablet.

Per coloro che vogliono diventare professionisti nel settore della Business Intelligence, SAP offre strumenti di analisi che permettono di supportare le aziende a prendere decisioni rapide e sicure.

SKILL FACTORY SAP ESSENTIAL

La Skill Factory SAP Essential, in partenza ad ottobre, in modalità smart learning, si pone l'obiettivo di introdurre laureati, laureandi o diplomati al mondo degli ERP e conoscere le caratteristiche fondamentali del sistema SAP, indispensabili per qualunque tipo di specializzazione futura.

Prevede i moduli seguenti:

SAP Overview

Definizione di un ERP; Il sistema SAP e la sua evoluzione; Moduli Sap; Landascape Sap; Customizing; Linguaggi di programmazioni Utilizzati; Definizione ed Utilizzo di una CR; Figure Professionali Sap; Metodologia ASAP; Fasi di Un Progetto Sap.

SAP Basis

Sap GUI; Puntamenti Sap; Navigazione Landascape, Creazione Utenza, Creazione di una CR, Trasporto di una CR.

SAP FI

Introduzione Modulo FI; Anagrafica Fornitori, Anagrafica Clienti, Anagrafica Conti coge, Registrazione Fattura Passiva; Registrazione Fattura Attiva, Registrazione Incassi, Registrazione Pagamenti; Visualizzazione delle scritture contabili sul Giornale Bollato; Cenni sul Customizing.

Le attività sincrone, erogate in presenza (Virtual Class), si terranno il LUNEDI', il MERCOLEDI' ed il VENERDI' dalle ore 10,00 alle ore 12,00.

Le attività di laboratorio verranno svolte in modalità asincrona, con supporto tecnico attraverso la piattaforma skillbook.it.

SCHEDA SKILL FACTORY SAP ESSENTIAL

Livello: BASE

Modalità didattica: SMART LEARNING

Virtual class: 40 ore (Sincrona)

Laboratorio: 40 ore (Asincrono)

Supporto didattico: Videolezioni

Destinatari: Laureati, Laureandi oppure Diplomati che vogliono diventare programmatori ABAP

Quorum: 6 iscritti

Competence Partner: KEYTECH

Docente: Dario Cirillo

Per la valutazione del livello di apprendimento sono previste le seguenti attività:

1) Esame di certificazione sulla piattaforma skillbook.it.

2) Prova di laboratorio individuale

3) Colloquio con Competence Partner KEYTECH

Il risultati di tutte le attività di verifica svolte, verranno indicati nell' ATTESTATO DI PARTECIPAZIONE .

A fine percorso, per tutti i partecipanti, è prevista un'attività di ORIENTAMENTO di un'ora, gestita dagli esperti della Skill Factory, con l'obiettivo di evidenziare i possibili sviluppi futuri e le opportunità offerte dal mondo della formazione e del lavoro.

Prezzo: 390 iva inclusa

Per informazioni e prenotazioni chiamare al numero 3270870141 dalle ore 9,00 alle ore 12,00 oppure invia una mail a segreteria@skillfactory.it.

COMPETENCE PARTNER

Keytech è una società di Consulenza e Formazione che supporta i clienti nei progetti di trasformazione tecnologica. L'azienda nel corso degli anni ha acquisito una grossa esperienza nell’implementazione di Sistemi Informativi e nell’Analisi dei processi di business, utilizzando le più evolute tecnologie SAP.

Attualmente è impegnata in progetti ad alto contenuto tecnologico, nei seguenti settori: Manufacturing, Food & Beverage, Pharma, Consumer Business e Aerospace & Defense, Public Sector.

Per maggiori informazioni clicca qui.

CURRICULUM DOCENTE

DARIO CIRILLO, consulente e formatore Sap.

Da diversi anni si occupa di progetti Sap per clienti come Enel ed Acea.

Ha maturato una grande esperienza nel settore amministrativo, contabile e fiscale e dal 2019 è responsabile della SAP Academy del società KEYTECH.

Progetta ed eroga i seguenti corsi: SAP FI, SAP CO, SAP MM, SAP SD, SAP ABAP, SAP Fiori, SAP IS-U.

Le Tue Aule

Le Tue Aule

I Tuoi Gruppi

I Tuoi Gruppi

Le Tue Selezioni

Le Tue Selezioni